Kubernetes ist eine Open-Source-Orchestrierungsplattform für Container. Sie abstrahiert die zugrunde liegende Infrastruktur und bietet eine Plattform für die Automatisierung der Bereitstellung, Skalierung und Verwaltung von containerisierten Anwendungen und Diensten. Im Wesentlichen ermöglicht Kubernetes Entwicklern, den gewünschten Zustand mithilfe deklarativer Konfigurationsdateien zu definieren, die Kubernetes dann automatisch verwaltet und wartet. Dieser Leitfaden befasst sich mit den wichtigsten Funktionen und Vorteilen von Kubernetes, einschließlich seiner Architektur und seines Ökosystems.

Erfahren Sie, wie Kubernetes die Zuverlässigkeit und Skalierbarkeit von Anwendungen verbessert, und entdecken Sie Best Practices für die Implementierung von Kubernetes in Ihrem Unternehmen. Das Verständnis von Kubernetes ist entscheidend für die effektive Nutzung der Container-Orchestrierung.

In vielerlei Hinsicht ähneln Container virtuellen Maschinen, der größte Unterschied besteht jedoch darin, dass sie in Bezug auf ihre Isolationseigenschaften weniger streng sind und die gemeinsame Nutzung des Betriebssystems durch mehrere Anwendungen ermöglichen. Container sind leichtgewichtig (insbesondere im Vergleich zu VMs), verfügen über ein eigenes Dateisystem und teilen sich CPU, Speicher und Prozessraum.

Container eignen sich hervorragend zum Bündeln und Ausführen Ihrer Anwendungen, erfordern jedoch eine gewisse Verwaltung. Kubernetes ist der De-facto-Standard für die Orchestrierung und Verwaltung von Containern. Es bietet eine umfassende Plattform für die Bereitstellung, Skalierung und Verwaltung containerisierter Anwendungen.

Warum Kubernetes verwenden?

Hier sind einige Gründe, warum Sie Kubernetes benötigen:

- Skalierbarkeit und Hochverfügbarkeit – Mit Kubernetes können Sie Ihre Anwendung ganz einfach nach Bedarf skalieren. Es ermöglicht eine hohe Verfügbarkeit, indem es ausgefallene Container automatisch neu startet, Container auf anderen Knoten neu plant, wenn ein Knoten ausfällt, und Container repliziert, um sicherzustellen, dass Ihre Anwendung immer verfügbar ist.

- Deklarativ – Konfiguration Kubernetes verwendet einen deklarativen Ansatz für die Konfiguration. Sie beschreiben den gewünschten Zustand Ihrer Anwendung, und Kubernetes kümmert sich um den Rest. Das bedeutet, dass Sie sich nicht um die zugrunde liegende Infrastruktur kümmern müssen und sich ganz auf die Logik Ihrer Anwendung konzentrieren können.

- Automatisierung – Kubernetes automatisiert viele Aufgaben, wie z. B. die Einführung von Updates, Skalierung und Selbstheilung. Es macht manuelle Eingriffe überflüssig, reduziert die Wahrscheinlichkeit menschlicher Fehler und entlastet Ihr Team.

- Portabilität – Kubernetes ist eine portable Plattform, die in jeder Cloud-, On-Premises- oder Hybridumgebung ausgeführt werden kann. Damit können Sie Ihre Anwendungen nahtlos zwischen verschiedenen Umgebungen verschieben, ohne die zugrunde liegende Infrastruktur zu ändern.

- Ökosystem – Kubernetes verfügt über ein großes und schnell wachsendes Ökosystem mit vielen Tools und Diensten.

- Ausfallsicherheit – Kubernetes bietet integrierte Mechanismen, die sicherstellen, dass Anwendungen auch dann immer verfügbar sind, wenn ein Container oder Knoten ausfällt. Es kann Container automatisch neu starten, sie auf funktionierende Knoten migrieren und sicherstellen, dass Anwendungen zuverlässig ausgeführt werden.

- Flexibilität – Kubernetes bietet eine flexible Plattform für die Bereitstellung und Verwaltung von Anwendungen. Es unterstützt eine Vielzahl von Container-Laufzeiten, darunter Docker und Container, und ermöglicht die Verwendung von Speicher-, Netzwerk- und Überwachungstools.

Was sind Container?

Bevor wir uns näher mit Kubernetes befassen, wollen wir zunächst verstehen, was Container sind. Container sind leichtgewichtige und portable ausführbare Einheiten, die Anwendungscode und alle seine Abhängigkeiten in einem einzigen Paket zusammenfassen. Sie bieten eine konsistente Laufzeitumgebung, unabhängig von der zugrunde liegenden Infrastruktur, wodurch das Verschieben von Anwendungen zwischen verschiedenen Umgebungen vereinfacht wird.

Wie funktioniert Kubernetes?

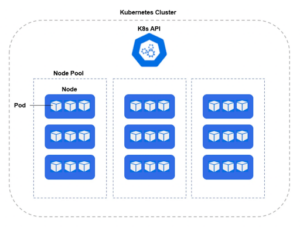

Kubernetes wird in einem Cluster bereitgestellt, während die physischen Server oder virtuellen Maschinen, die Teil des Clusters sind, als Worker-Knoten bezeichnet werden. Jeder Worker-Knoten betreibt eine Reihe von Pods, bei denen es sich um eine logische Gruppierung von einem oder mehreren Containern handelt, die innerhalb jedes Pods ausgeführt werden.

Kubernetes verwendet eine Reihe von APIs für die Kommunikation mit der zugrunde liegenden Infrastruktur, wie z. B. Container-Laufzeitumgebung, Speicher und Netzwerk. Zu den Kernkomponenten von Kubernetes gehören:

- API-Server – Die Steuerungsebene von Kubernetes. Sie stellt die Kubernetes-API bereit, über die Clients mit dem Kubernetes-Cluster kommunizieren können. Der API-Server ist für die Authentifizierung und Autorisierung von Client-Anfragen, die Validierung und Verarbeitung von API-Objekten sowie die Aktualisierung des Status des Clusters verantwortlich.

- Controller-Manager – Controller (auch als kube-controller-manager bezeichnet) sind für die Aufrechterhaltung des gewünschten Zustands Ihrer Anwendung verantwortlich. Sie stellen sicher, dass die richtige Anzahl von Pods ausgeführt wird und dass diese fehlerfrei und auf dem neuesten Stand sind. Der Controller Manager ist für die Aufrechterhaltung des gewünschten Zustands des Clusters verantwortlich. Er überwacht den Zustand des Clusters über den API-Server und vergleicht ihn mit dem in den Kubernetes-Objekten festgelegten gewünschten Zustand. Wenn es einen Unterschied zwischen dem aktuellen und dem gewünschten Zustand gibt, ergreift der Controller Manager geeignete Maßnahmen, um den Cluster wieder in den gewünschten Zustand zu versetzen.

- Scheduler – Verantwortlich für die Planung von Workloads auf den Worker-Knoten des Clusters. Er überwacht neue Workloads, die geplant werden müssen, und wählt anhand der Ressourcenanforderungen und der Verfügbarkeit der Knoten einen geeigneten Knoten für die Ausführung der Workload aus.

- Kubernetes-Dienste – API-Objekte, die es ermöglichen, einen oder mehrere Cluster-Pods innerhalb Ihres Clusters oder extern für das Netzwerk freizugeben.

- etcd – Der verteilte Schlüsselwertspeicher für die Konfigurationsdaten eines Clusters. Er bietet eine konsistente und zuverlässige Möglichkeit, Konfigurationsdaten im gesamten Cluster zu speichern und abzurufen.

Einige Funktionen, die für Sicherheitsexperten relevant sind:

- Namespace – Eine logische Konstruktion, die die Isolierung von Ressourcen innerhalb des Clusters ermöglicht. Ein Namespace trennt Benutzer, Anwendungen und Ressourcen in einen bestimmten Bereich.

- SecurityContext – definiert Berechtigungen und Fähigkeiten für einzelne Pods und Container.

- Helm Chart – Ein Manifest aus YAML-Dateien für Bereitstellungen, Dienste, Geheimnisse und Konfigurationszuordnungen zur Konfiguration Ihrer Kubernetes-Bereitstellung.

- DaemonSet – Ein grundlegender Controller, der sicherstellt, dass ein bestimmter Pod auf jedem Knoten oder einer bestimmten Teilmenge von Knoten innerhalb eines Clusters ausgeführt wird. Dies ist entscheidend für die Bereitstellung von Diensten auf Systemebene, die einen konsistenten Betrieb im gesamten Cluster erfordern. Beispiele für solche Dienste sind Protokollsammlungen, Überwachungsagenten und Netzwerkmanagement-Tools. Der DaemonSet-Controller automatisiert die Verwaltung dieser Pods, indem er sie auf neu hinzugefügten Knoten erstellt und entfernt, wenn Knoten entfernt werden, und so vollständige Beobachtbarkeit, Sicherheit und Netzwerkverwaltung in der gesamten Infrastruktur gewährleistet.

Kubernetes-Bereitstellung

Obwohl Kubernetes über das gesamte Spektrum der Hybrid Cloud hinweg bereitgestellt werden kann, wird die Mehrheit der K8s-Implementierungen über Infrastructure-as-a-Service (IaaS)-Tools verwaltet, wie beispielsweise Amazon Elastic Kubernetes Service (EKS), Google GCPs Google Kubernetes Engine (GKE) oder Microsoft Azure's Azure Kubernetes Service (AKS). Durch die Verwendung dieser Kubernetes-as-a-Service-Tools können sich Teams auf die Entwicklung und Bereitstellung konzentrieren, während der Cloud-Dienstanbieter (CSP) die Kernaspekte der K8s-Dienste kuratiert und aktualisiert. Wie immer bei Cloud-Dienstanbietern gibt es auch hier ein gemeinsames Verantwortungsmodell, das in Bezug auf die Sicherheit zu berücksichtigen ist.

Fazit

Zusammenfassend lässt sich sagen, dass Kubernetes zwar zahlreiche Vorteile für die Verwaltung containerisierter Anwendungen bietet, Sicherheit immer ein vorrangiges Anliegen für Unternehmen sein. Singularity Cloud Security hilft Unternehmen, sich vor modernen Bedrohungen zu schützen, indem es sowohl proaktive als auch reaktive Sicherheitskontrollen für Cloud- und Containerumgebungen bietet.Singularity Cloud Workload Security ist eine agentenbasierte Sicherheitslösung, die autonomen Laufzeitschutz und forensische Telemetriedatenerfassung für alle Cloud-Computing- und Containerumgebungen unabhängig von ihrer Lebensdauer bietet. Singularity Cloud Native Security ist eine agentenlose CNAPP-Lösung für Transparenz und Sicherheitskontrollen sowohl in Build- als auch in Laufzeitumgebungen. Sicherheit für Vorlagen, Images, Hosts, Identitäten, Berechtigungen, Zugriffsrechte und zugehörige Konfigurationen.

Durch die Integration von Singularity Cloud Security in ihre Kubernetes-Umgebungen können Unternehmen ihre containerisierten Anwendungen um eine zusätzliche Sicherheitsebene erweitern und sich vor Cyberbedrohungen schützen.

Dadurch können Kunden sicher sein, dass ihre Anwendungen und Daten sicher und geschützt sind, sodass sie sich auf das Erreichen ihrer Geschäftsziele konzentrieren können, ohne sich um Fragen der Cybersicherheit sorgen zu müssen.

SentinelOne in Aktion sehen

Entdecken Sie in einer persönlichen Demo mit einem SentinelOne-Produktexperten, wie KI-gestützte Cloud-Sicherheit Ihr Unternehmen schützen kann.

Demo anfordernKubernetes FAQs

Kubernetes ist eine Open-Source-Plattform, die die Bereitstellung, Skalierung und Verwaltung von containerisierten Anwendungen auf Serverclustern automatisiert. Es stellt sicher, dass Container weiterlaufen, verteilt die Last und übernimmt Rollouts oder Rollbacks.

Kubernetes wurde ursprünglich von Google entwickelt und gruppiert Container in logische Einheiten, sogenannte Pods, und verwendet eine Steuerungsebene, um den gewünschten Zustand von Anwendungen aufrechtzuerhalten, wodurch groß angelegte Containeroperationen zuverlässig und wiederholbar werden.

Ein Kubernetes-Cluster verfügt über eine Steuerungsebene und Worker-Knoten. Die Steuerungsebene umfasst kube-apiserver (das API-Frontend), etcd (einen Schlüsselwertspeicher), kube-scheduler und kube-controller-manager.

Worker-Knoten führen kubelet (Knotenagent), kube-proxy (Netzwerk) und eine Container-Laufzeitumgebung wie containerd aus. Optionale Add-ons – DNS, Dashboards, Protokollierung und Überwachung – erweitern die Funktionalität und unterstützen den Betrieb.

Ein Deployment verwaltet zustandslose Pods, stellt sicher, dass eine bestimmte Anzahl ausgeführt wird, und aktualisiert sie auf kontrollierte Weise. Ein StatefulSet verwaltet zustandsbehaftete Anwendungen, indem es jedem Pod eine stabile Identität und persistenten Speicher zuweist, was ideal für Datenbanken ist. Ein DaemonSet führt einen Pod pro Knoten (oder pro ausgewählten Knoten) aus und stellt so sicher, dass eine Kopie eines Dienstes – wie ein Log-Collector oder Node-Agent – auf jedem Knoten ausgeführt wird.

Unter Linux oder Windows können Sie kubeadm verwenden: Installieren Sie Docker oder containerd, kubeadm, kubelet und kubectl und führen Sie dann kubeadm init (Control Plane) oder kubeadm join (Worker) aus. Für einen lokalen Single-Node-Cluster installiert Minikube eine VM oder einen Container mit einer Control Plane und kubelet: minikube start richtet alles automatisch ein. Anschließend verwenden Sie kubectl, um mit Ihrem Cluster zu interagieren.

kubectl ist das Befehlszeilentool für Kubernetes. Es sendet REST-API-Anfragen an den kube-apiserver, sodass Sie Ressourcen wie Pods, Deployments und Services erstellen, überprüfen, aktualisieren oder löschen können. Sie können Protokolle anzeigen (kubectl logs), Container ausführen (kubectl exec), YAML-Manifeste anwenden (kubectl apply -f) und Cluster direkt von Ihrem Terminal aus Fehler beheben.

Prometheus in Kombination mit Grafana bietet Metrikerfassung und -visualisierung und verfolgt CPU-, Speicher- und benutzerdefinierte Anwendungsdaten. Fluentd oder Filebeat können Containerprotokolle an Elasticsearch weiterleiten und sie dann in Kibana visualisieren. Weitere Optionen sind der Kubernetes Metrics Server für die automatische Skalierung, EFK-Stacks (Elasticsearch-Fluentd-Kibana) und gehostete Dienste wie Datadog oder Sysdig.

SentinelOne stellt einen leichtgewichtigen Sentinel-Agenten auf jedem Knoten als DaemonSet bereit und schützt Live-Container zur Laufzeit mit statischer und verhaltensbasierter KI. Es ergänzt Scans vor der Produktion durch Echtzeit-Prävention, -Erkennung und -Reaktion auf Malware, dateilose Bedrohungen und Ransomware. Der Agent lässt sich in Singularity XDR integrieren und sorgt so für einheitliche Transparenz und automatisierte Fehlerbehebung.

Ja. Der Kubernetes Sentinel-Agent von SentinelOne bietet Laufzeitschutz und EDR-Transparenz für containerisierte Workloads. Er arbeitet vollständig im Benutzerbereich – ohne Kernel-Module – und bietet Threat Hunting, Storyline Active Response und vollständige forensische Telemetrie für alle gängigen Linux-Distributionen und Managed Services wie AWS EKS und Azure AKS.