Kubernetes è una piattaforma di orchestrazione open source per container. Astrae l'infrastruttura sottostante e fornisce una piattaforma per automatizzare la distribuzione, il ridimensionamento e la gestione di applicazioni e servizi containerizzati. In sostanza, Kubernetes consente agli sviluppatori di definire lo stato desiderato utilizzando file di configurazione dichiarativi, che Kubernetes gestisce e mantiene automaticamente. Questa guida esplora le caratteristiche e i vantaggi principali di Kubernetes, compresa la sua architettura e il suo ecosistema.

Scoprite come Kubernetes migliora l'affidabilità e la scalabilità delle applicazioni e scoprite le migliori pratiche per implementare Kubernetes nella vostra organizzazione. Comprendere Kubernetes è fondamentale per sfruttare efficacemente l'orchestrazione dei container.

Per molti aspetti, i container sono molto simili alle macchine virtuali; tuttavia, la differenza principale è che hanno proprietà di isolamento più flessibili, consentendo la condivisione del sistema operativo tra le applicazioni. I container sono leggeri (soprattutto rispetto alle macchine virtuali), hanno un proprio file system e condividono CPU, memoria e spazio di processo.

I container sono un ottimo modo per raggruppare ed eseguire le applicazioni, ma richiedono una gestione. Kubernetes è lo standard de facto per l'orchestrazione e la gestione dei container. Fornisce una piattaforma completa per l'implementazione, il ridimensionamento e la gestione delle applicazioni containerizzate.

Perché utilizzare Kubernetes?

Ecco alcuni motivi per cui avete bisogno di Kubernetes:

- Scalabilità e alta disponibilità – Kubernetes semplifica il ridimensionamento dell'applicazione in base alle esigenze. Garantisce un'elevata disponibilità riavviando automaticamente i container che non funzionano, riprogrammando i container su altri nodi in caso di guasto di un nodo e replicando i container per garantire che l'applicazione sia sempre disponibile.

- Dichiarativo – Configurazione Kubernetes utilizza un approccio dichiarativo alla configurazione. È sufficiente descrivere lo stato desiderato dell'applicazione e Kubernetes si occuperà del resto. Ciò significa che non è necessario preoccuparsi dell'infrastruttura sottostante e ci si può concentrare sulla logica dell'applicazione.

- Automazione – Kubernetes automatizza molte attività, come il rollout degli aggiornamenti, il ridimensionamento e l'auto-riparazione. Elimina l'intervento manuale, riducendo la probabilità di errori umani e liberando tempo per il tuo team.

- Portabilità – Kubernetes è una piattaforma portatile che funziona su qualsiasi ambiente cloud, locale o ibrido. Consente di spostare le applicazioni senza soluzione di continuità tra diversi ambienti senza modificare l'infrastruttura sottostante.

- Ecosistema – Kubernetes ha un ecosistema ampio e in rapida crescita con molti strumenti e servizi disponibili.

- Resilienza – Kubernetes fornisce meccanismi integrati per garantire che le applicazioni siano sempre disponibili, anche in caso di guasto di un container o di un nodo. È in grado di riavviare automaticamente i container, migrarli su nodi funzionanti e garantire che le applicazioni funzionino in modo affidabile.

- Flessibilità – Kubernetes fornisce una piattaforma flessibile per la distribuzione e la gestione delle applicazioni. Supporta un'ampia gamma di runtime dei container, inclusi Docker e container, e consente di utilizzare strumenti di archiviazione, networking e monitoraggio.

Cosa sono i container?

Prima di approfondire Kubernetes, cerchiamo di capire cosa sono i container. I container sono unità eseguibili leggere e portatili che racchiudono il codice dell'applicazione e tutte le sue dipendenze in un unico pacchetto. Forniscono un ambiente di runtime coerente, indipendentemente dall'infrastruttura sottostante, facilitando lo spostamento delle applicazioni tra ambienti diversi.

Come funziona Kubernetes?

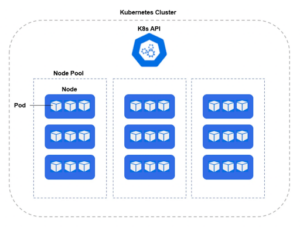

Kubernetes viene distribuito in un cluster, mentre i server fisici o le macchine virtuali che fanno parte del cluster sono noti come nodi di lavoro. Ogni nodo di lavoro gestisce una serie di pod, che sono un raggruppamento logico di uno o più container in esecuzione all'interno di ciascun pod.

Kubernetes utilizza una serie di API per comunicare con l'infrastruttura sottostante, come il runtime dei container, lo storage e la rete. Alcuni dei componenti principali di Kubernetes includono:

- Server API – Il piano di controllo di Kubernetes. Espone l'API Kubernetes, che consente ai client di comunicare con il cluster Kubernetes. Il server API è responsabile dell'autenticazione e dell'autorizzazione delle richieste dei client, della convalida e dell'elaborazione degli oggetti API e dell'aggiornamento dello stato del cluster.

- Controller Manager – I controller (chiamati anche kube-controller-manager) sono responsabili del mantenimento dello stato desiderato dell'applicazione. Garantiscono che sia in esecuzione il numero corretto di pod e che questi siano integri e aggiornati. Il controller manager è responsabile del mantenimento dello stato desiderato del cluster. Monitora lo stato del cluster tramite il server API e lo confronta con lo stato desiderato specificato negli oggetti Kubernetes. Se c'è una differenza tra lo stato attuale e quello desiderato, il controller manager intraprende le azioni appropriate per riportare il cluster allo stato desiderato.

- Scheduler – Responsabile della pianificazione dei carichi di lavoro sui nodi di lavoro del cluster. Monitora i nuovi carichi di lavoro che devono essere pianificati e seleziona un nodo appropriato per eseguire il carico di lavoro in base ai requisiti di risorse e alla disponibilità del nodo.

- Servizi Kubernetes – Oggetti API che consentono l'esposizione di uno o più pod del cluster alla rete all'interno del cluster stesso o all'esterno.

- etcd – L'archivio distribuito chiave-valore per i dati di configurazione di un cluster. Fornisce un modo coerente e affidabile per archiviare e recuperare i dati di configurazione in tutto il cluster.

Diverse caratteristiche rilevanti che i professionisti della sicurezza devono conoscere:

- Namespace – Una struttura logica che consente l'isolamento delle risorse all'interno del cluster. Un namespace separa utenti, app e risorse in un ambito specifico.

- SecurityContext: definisce i privilegi e le capacità dei singoli pod e container.

- Helm Chart – Un manifesto di file YAML per distribuzioni, servizi, segreti e mappe di configurazione per configurare la distribuzione Kubernetes.

- DaemonSet – un controller fondamentale che garantisce l'esecuzione di un pod specifico su ogni nodo, o su un sottoinsieme mirato di nodi, all'interno di un cluster. Questo è fondamentale per l'implementazione di servizi a livello di sistema che richiedono un funzionamento coerente nell'intero cluster. Esempi di tali servizi includono raccoglitori di log, agenti di monitoraggio e strumenti di gestione della rete. Il controller DaemonSet automatizza la gestione di questi pod, creandoli sui nodi appena aggiunti e rimuovendoli quando i nodi vengono rimossi, garantendo piena osservabilità, sicurezza e gestione della rete in tutta l'infrastruttura.

Distribuzione Kubernetes

Sebbene Kubernetes possa essere distribuito su tutto lo spettro del cloud ibrido, la maggior parte delle implementazioni K8s sono gestite tramite strumenti Infrastructure-as-a-Service (IaaS), come Amazon Elastic Kubernetes Service (EKS), Google GCP’s Google Kubernetes Engine (GKE) o il servizio Azure Kubernetes Service (AKS) di Microsoft Azure. Utilizzando questi strumenti Kubernetes-as-a-service, i team possono concentrarsi sulla creazione e l'implementazione, mentre il fornitore di servizi cloud (CSP) cura e aggiorna gli aspetti fondamentali dei servizi K8s. Come sempre con i fornitori di servizi cloud, quando si tratta di sicurezza è ancora necessario considerare un modello di responsabilità condivisa.

Conclusione

In conclusione, sebbene Kubernetes offra numerosi vantaggi per la gestione delle applicazioni containerizzate, la sicurezza dovrebbe sempre essere una priorità assoluta per le aziende. Singularity Cloud Security aiuta le aziende a proteggersi dalle minacce moderne offrendo controlli di sicurezza proattivi e reattivi per ambienti cloud e container.Singularity Cloud Workload Security è una soluzione di sicurezza basata su agenti che fornisce protezione autonoma durante l'esecuzione e raccolta di dati telemetrici forensi su tutti i cloud compute e container, indipendentemente dalla loro durata. Singularity Cloud Native Security è un CNAPP senza agenti che garantisce visibilità e controlli di sicurezza sia sugli ambienti di compilazione che su quelli di esecuzione. Sicurezza per modelli, immagini, host, identità, privilegi, autorizzazioni e configurazioni associate.

Incorporando Singularity Cloud Security nei propri ambienti Kubernetes, le aziende possono aggiungere un ulteriore livello di sicurezza alle proprie applicazioni containerizzate e proteggersi dalle minacce informatiche.

Di conseguenza, i clienti possono stare tranquilli che le loro applicazioni e i loro dati sono al sicuro, consentendo loro di concentrarsi sul raggiungimento dei propri obiettivi aziendali senza preoccuparsi dei problemi di sicurezza informatica.

Vedere SentinelOne in azione

Scoprite come la sicurezza del cloud basata sull'intelligenza artificiale può proteggere la vostra organizzazione con una demo individuale con un esperto dei prodotti SentinelOne.

Richiedi una demoDomande frequenti su Kubernetes

Kubernetes è una piattaforma open source che automatizza la distribuzione, il ridimensionamento e la gestione delle applicazioni containerizzate su cluster di server. Garantisce il funzionamento dei container, distribuisce il carico e gestisce i rollout o i rollback.

Originariamente sviluppato da Google, Kubernetes raggruppa i container in unità logiche chiamate Pod e utilizza un piano di controllo per mantenere lo stato desiderato delle applicazioni, rendendo affidabili e ripetibili le operazioni su container su larga scala.

Un cluster Kubernetes è composto da un piano di controllo e da nodi di lavoro. Il piano di controllo include kube-apiserver (il frontend API), etcd (un archivio chiave-valore), kube-scheduler e kube-controller-manager.

I nodi di lavoro eseguono kubelet (agente di nodo), kube-proxy (rete) e un runtime di container come containerd. I componenti aggiuntivi opzionali (DNS, dashboard, registrazione e monitoraggio) estendono le funzionalità e facilitano le operazioni.

Un Deployment gestisce i Pod stateless, garantendo che venga eseguito un numero specificato e aggiornandoli in modo controllato. Uno StatefulSet gestisce le applicazioni stateful assegnando a ciascun Pod un'identità stabile e uno storage persistente, ideale per i database. Un DaemonSet esegue un Pod per nodo (o per nodi selezionati), garantendo che una copia di un servizio, come un log collector o un node-agent, sia in esecuzione su ogni nodo.

Su Linux o Windows, è possibile utilizzare kubeadm: installare Docker o containerd, kubeadm, kubelet e kubectl, quindi eseguire kubeadm init (piano di controllo) o kubeadm join (worker). Per un cluster locale a nodo singolo, Minikube installa una VM o un container con un piano di controllo e kubelet: minikube start configura tutto automaticamente. È quindi possibile utilizzare kubectl per interagire con il cluster.

kubectl è lo strumento da riga di comando per Kubernetes. Invia richieste API REST al kube-apiserver, consentendo di creare, ispezionare, aggiornare o eliminare risorse come pod, distribuzioni e servizi. È possibile visualizzare i log (kubectl logs), eseguire comandi nei container (kubectl exec), applicare manifest YAML (kubectl apply -f) e risolvere i problemi dei cluster direttamente dal terminale.

Prometheus abbinato a Grafana offre la raccolta e la visualizzazione di metriche, monitorando CPU, memoria e dati delle applicazioni personalizzate. Fluentd o Filebeat possono inoltrare i log dei container a Elasticsearch, per poi visualizzarli in Kibana. Altre opzioni includono Kubernetes Metrics Server per il ridimensionamento automatico, stack EFK (Elasticsearch-Fluentd-Kibana) e servizi ospitati come Datadog o Sysdig.

SentinelOne distribuisce un agente Sentinel leggero su ogni nodo come DaemonSet, proteggendo i container attivi in fase di esecuzione con IA statica e comportamentale. Integra le scansioni pre-produzione con prevenzione, rilevamento e risposta in tempo reale per malware, minacce senza file e ransomware. L'agente si integra in Singularity XDR per garantire visibilità unificata e correzione automatizzata.

Sì. L'agente Kubernetes Sentinel di SentinelOne offre protezione runtime e visibilità EDR per i carichi di lavoro containerizzati. Funziona interamente nello spazio utente, senza moduli del kernel, fornendo ricerca delle minacce, risposta attiva Storyline e telemetria forense completa su tutte le principali distribuzioni Linux e servizi gestiti come AWS EKS e Azure AKS.