Kubernetes est une plateforme d'orchestration open source pour conteneurs. Elle abstrait l'infrastructure sous-jacente et fournit une plateforme permettant d'automatiser le déploiement, la mise à l'échelle et la gestion des applications et services conteneurisés. Essentiellement, Kubernetes permet aux développeurs de définir l'état souhaité à l'aide de fichiers de configuration déclaratifs, que Kubernetes gère et maintient ensuite automatiquement. Ce guide explore les principales fonctionnalités et avantages de Kubernetes, y compris son architecture et son écosystème.

Découvrez comment Kubernetes améliore la fiabilité et l'évolutivité des applications, et découvrez les meilleures pratiques pour mettre en œuvre Kubernetes dans votre organisation. Il est essentiel de comprendre Kubernetes pour tirer efficacement parti de l'orchestration des conteneurs.

À bien des égards, les conteneurs sont très similaires aux machines virtuelles ; cependant, la plus grande différence réside dans le fait qu'ils sont plus souples en termes de propriétés d'isolation, ce qui permet le partage du système d'exploitation entre les applications. Les conteneurs sont légers (en particulier par rapport aux machines virtuelles), disposent de leur propre système de fichiers et partagent le processeur, la mémoire et l'espace de traitement.

Les conteneurs constituent un excellent moyen de regrouper et d'exécuter vos applications, mais ils nécessitent une gestion. Kubernetes est la norme de facto pour l'orchestration et la gestion des conteneurs. Il fournit une plateforme complète pour le déploiement, la mise à l'échelle et la gestion des applications conteneurisées.

Pourquoi utiliser Kubernetes ?

Voici quelques raisons pour lesquelles vous avez besoin de Kubernetes :

- Évolutivité et haute disponibilité – Kubernetes facilite la mise à l'échelle de votre application selon vos besoins. Il garantit une haute disponibilité en redémarrant automatiquement les conteneurs défaillants, en replanifiant les conteneurs sur d'autres nœuds si un nœud tombe en panne et en répliquant les conteneurs pour que votre application soit toujours disponible.

- Déclaratif – Configuration Kubernetes utilise une approche déclarative pour la configuration. Vous décrivez l'état souhaité de votre application, et Kubernetes s'occupe du reste. Cela signifie que vous n'avez pas à vous soucier de l'infrastructure sous-jacente et que vous pouvez vous concentrer sur la logique de votre application.

- Automatisation – Kubernetes automatise de nombreuses tâches, telles que le déploiement des mises à jour, la mise à l'échelle et l'auto-réparation. Il élimine les interventions manuelles, réduisant ainsi le risque d'erreur humaine et libérant du temps pour votre équipe.

- Portabilité – Kubernetes est une plateforme portable qui fonctionne sur n'importe quel environnement cloud, sur site ou hybride. Elle vous permet de déplacer vos applications de manière transparente entre différents environnements sans modifier l'infrastructure sous-jacente.

- Écosystème – Kubernetes dispose d'un écosystème vaste et en pleine expansion, avec de nombreux outils et services disponibles.

- Résilience – Kubernetes fournit des mécanismes intégrés pour garantir la disponibilité permanente des applications, même en cas de défaillance d'un conteneur ou d'un nœud. Il peut redémarrer automatiquement les conteneurs, les migrer vers des nœuds sains et garantir le fonctionnement fiable des applications.

- Flexibilité – Kubernetes fournit une plateforme flexible pour le déploiement et la gestion des applications. Il prend en charge un large éventail de runtimes de conteneurs, notamment Docker et les conteneurs, et vous permet d'utiliser des outils de stockage, de mise en réseau et de surveillance.

Que sont les conteneurs ?

Avant d'approfondir le sujet Kubernetes, voyons d'abord ce que sont les conteneurs. Les conteneurs sont des unités exécutables légères et portables qui regroupent le code d'une application et toutes ses dépendances dans un seul ensemble. Ils fournissent un environnement d'exécution cohérent, quelle que soit l'infrastructure sous-jacente, ce qui facilite le déplacement des applications entre différents environnements.

Comment fonctionne Kubernetes ?

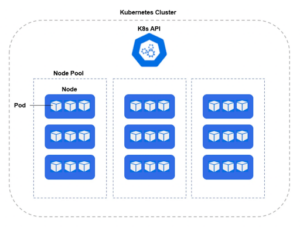

Kubernetes est déployé dans un cluster, tandis que les serveurs physiques ou les machines virtuelles qui font partie du cluster sont appelés nœuds de travail. Chaque nœud de travail exploite un certain nombre de pods, qui sont un regroupement logique d'un ou plusieurs conteneurs s'exécutant dans chaque pod.

Kubernetes utilise un ensemble d'API pour communiquer avec l'infrastructure sous-jacente, telle que le runtime des conteneurs, le stockage et la mise en réseau. Voici quelques-uns des composants essentiels de Kubernetes :

- Serveur API – Le plan de contrôle de Kubernetes. Il expose l'API Kubernetes, qui permet aux clients de communiquer avec le cluster Kubernetes. Le serveur API est chargé d'authentifier et d'autoriser les requêtes des clients, de valider et de traiter les objets API, et de mettre à jour l'état du cluster.

- Gestionnaire de contrôleurs – Les contrôleurs (également appelés kube-controller-manager) sont chargés de maintenir l'état souhaité de votre application. Ils veillent à ce que le nombre correct de pods soit en cours d'exécution et à ce qu'ils soient en bon état et à jour. Le gestionnaire de contrôleurs est chargé de maintenir l'état souhaité du cluster. Il surveille l'état du cluster via le serveur API et le compare à l'état souhaité spécifié dans les objets Kubernetes. S'il existe une différence entre l'état actuel et l'état souhaité, le gestionnaire de contrôleurs prend les mesures appropriées pour ramener le cluster à l'état souhaité.

- Planificateur – Il est chargé de planifier les charges de travail sur les nœuds de travail du cluster. Il surveille les nouvelles charges de travail à planifier et sélectionne un nœud approprié pour exécuter la charge de travail en fonction des besoins en ressources et de la disponibilité du nœud.

- Services Kubernetes – Objets API qui permettent d'exposer un ou plusieurs pods du cluster au réseau, soit au sein de votre cluster, soit en externe.

- etcd – Magasin distribué de clés-valeurs pour les données de configuration d'un cluster. Il offre un moyen cohérent et fiable de stocker et de récupérer les données de configuration à travers le cluster.

Plusieurs fonctionnalités importantes à connaître pour les professionnels de la sécurité :

- Espace de noms – Une construction logique qui permet d'isoler les ressources au sein du cluster. Un espace de noms sépare les utilisateurs, les applications et les ressources dans un périmètre spécifique.

- SecurityContext – définit les privilèges et les capacités pour les pods et les conteneurs individuels.

- Helm Chart – Manifeste de fichiers YAML pour les déploiements, les services, les secrets et les cartes de configuration permettant de configurer votre déploiement Kubernetes.

- DaemonSet – un contrôleur fondamental qui garantit qu'un pod spécifique s'exécute sur chaque nœud, ou sur un sous-ensemble ciblé de nœuds, au sein d'un cluster. Ceci est essentiel pour déployer des services au niveau du système qui nécessitent un fonctionnement cohérent sur l'ensemble du cluster. Parmi les exemples de tels services, on peut citer les collecteurs de journaux, les agents de surveillance et les outils de gestion de réseau. Le contrôleur DaemonSet automatise la gestion de ces pods, en les créant sur les nœuds nouvellement ajoutés et en les supprimant lorsque les nœuds sont supprimés, garantissant ainsi une observabilité, une sécurité et une gestion du réseau complètes à travers l'infrastructure.

Déploiement Kubernetes

Bien que Kubernetes puisse être déployé sur l'ensemble du spectre du cloud hybride, la majorité des implémentations K8s sont gérées via des outils Infrastructure-as-a-Service (IaaS), tels qu'Amazon Elastic Kubernetes Service (EKS), Google GCP Google Kubernetes Engine (GKE) ou Microsoft AzureAzure Kubernetes Service (AKS). Grâce à ces outils Kubernetes-as-a-service, les équipes peuvent se concentrer sur le développement et le déploiement, tandis que le fournisseur de services cloud (CSP) gère et met à jour les aspects fondamentaux des services K8s. Comme toujours avec les fournisseurs de services cloud, il existe un modèle de partage des responsabilités à prendre en compte en matière de sécurité.

Conclusion

En conclusion, si Kubernetes offre de nombreux avantages pour la gestion des applications conteneurisées, la sécurité doit toujours rester une priorité pour les entreprises. Singularity Cloud Security aide les entreprises à se protéger contre les menaces modernes en offrant des contrôles de sécurité proactifs et réactifs pour les environnements cloud et conteneurisés.Singularity Cloud Workload Security est une solution de sécurité basée sur un agent qui fournit une protection autonome en temps réel et une collecte de données télémétriques à des fins d'analyse sur tous les environnements de cloud computing et de conteneurs, quelle que soit leur durée de vie. Singularity Cloud Native Security est une solution CNAPP sans agent qui offre une visibilité et des contrôles de sécurité sur les environnements de développement et d'exécution. Sécurité pour les modèles, les images, les hôtes, les identités, les privilèges, les autorisations et les configurations associées.

En intégrant Singularity Cloud Security à leurs environnements Kubernetes, les entreprises peuvent ajouter une couche de sécurité supplémentaire à leurs applications conteneurisées et se protéger contre les cybermenaces.

Les clients ont ainsi l'assurance que leurs applications et leurs données sont en sécurité, ce qui leur permet de se concentrer sur la réalisation de leurs objectifs commerciaux sans se soucier des questions de cybersécurité.

Voir SentinelOne en action

Découvrez comment la sécurité du cloud alimentée par l'IA peut protéger votre organisation lors d'une démonstration individuelle avec un expert produit de SentinelOne.

Obtenir une démonstrationFAQ Kubernetes

Kubernetes est une plateforme open source qui automatise le déploiement, la mise à l'échelle et la gestion d'applications conteneurisées sur des clusters de serveurs. Elle garantit le fonctionnement continu des conteneurs, répartit la charge et gère les déploiements ou les restaurations.

Initialement développé par Google, Kubernetes regroupe les conteneurs en unités logiques appelées " pods " et utilise un plan de contrôle pour maintenir l'état souhaité des applications, rendant ainsi les opérations de conteneurs à grande échelle fiables et reproductibles.

Un cluster Kubernetes comprend un plan de contrôle et des nœuds de travail. Le plan de contrôle comprend kube-apiserver (l'interface API), etcd (un magasin clé-valeur), kube-scheduler et kube-controller-manager.

Les nœuds de travail exécutent kubelet (agent de nœud), kube-proxy (réseau) et un runtime de conteneur tel que containerd. Des modules complémentaires optionnels (DNS, tableaux de bord, journalisation et surveillance) étendent les fonctionnalités et facilitent les opérations.

Un déploiement gère les pods sans état, en garantissant qu'un nombre spécifié s'exécute et en les mettant à jour de manière contrôlée. Un StatefulSet gère les applications avec état en attribuant à chaque pod une identité stable et un stockage persistant, ce qui est idéal pour les bases de données. Un DaemonSet exécute un pod par nœud (ou par nœuds sélectionnés), garantissant ainsi qu'une copie d'un service, tel qu'un collecteur de journaux ou un agent de nœud, s'exécute sur chaque nœud.

Sous Linux ou Windows, vous pouvez utiliser kubeadm : installez Docker ou containerd, kubeadm, kubelet et kubectl, puis exécutez kubeadm init (plan de contrôle) ou kubeadm join (travailleur). Pour un cluster local à nœud unique, Minikube installe une machine virtuelle ou un conteneur avec un plan de contrôle et kubelet : minikube start configure tout automatiquement. Vous utilisez ensuite kubectl pour interagir avec votre cluster.

kubectl est l'outil en ligne de commande pour Kubernetes. Il envoie des requêtes API REST au kube-apiserver, vous permettant de créer, d'inspecter, de mettre à jour ou de supprimer des ressources telles que des pods, des déploiements et des services. Vous pouvez afficher les journaux (kubectl logs), exécuter des conteneurs (kubectl exec), appliquer des manifestes YAML (kubectl apply -f) et dépanner des clusters directement depuis votre terminal.

Prometheus associé à Grafana permet la collecte et la visualisation de métriques, le suivi du CPU, de la mémoire et des données d'applications personnalisées. Fluentd ou Filebeat peuvent transférer les journaux des conteneurs vers Elasticsearch, puis les visualiser dans Kibana. D'autres options sont disponibles, notamment Kubernetes Metrics Server pour l'autoscaling, les piles EFK (Elasticsearch-Fluentd-Kibana) et les services hébergés tels que Datadog ou Sysdig.

SentinelOne déploie un agent Sentinel léger sur chaque nœud en tant que DaemonSet, protégeant les conteneurs actifs lors de l'exécution grâce à une IA statique et comportementale. Il complète les analyses pré-production par une prévention, une détection et une réponse en temps réel pour les logiciels malveillants, les menaces sans fichier et les ransomwares. L'agent s'intègre à Singularity XDR pour une visibilité unifiée et une correction automatisée.

Oui. L'agent Kubernetes Sentinel de SentinelOne offre une protection en temps réel et une visibilité EDR pour les charges de travail conteneurisées. Il fonctionne entièrement dans l'espace utilisateur, sans modules noyau, et offre des fonctionnalités de recherche de menaces, de réponse active Storyline et de télémétrie forensic complète sur toutes les principales distributions Linux et les services gérés tels que AWS EKS et Azure AKS.